ディープラーニングはニューラルネットワークの一形態であり、その層数を深くした構造を持つが、単に層数を深くしただけではなく、入力画像の形状を捉えるための工夫が施されている。今回はその構造について説明する。

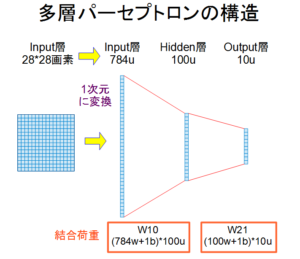

まず、画像を認識する従来の基本的なニューラルネットワークの構造を図1に示す。これは多層パーセプトロンと呼ばれるニューラルネットワークで、この例では入力層1層、中間層であるHidden層1層、出力層1層の3層構造を有している。

Input層には写真などの2次元の画像が用いられるが、図1に示したように、2次元の画像は1次元に変換されて、入力される。この2次元から1次元への変換は、2次元の各行を単純に1行につないで並べるだけの変換である。

手書き数字(0~9)画像の代表的なデータベースであるMNISTを用いて画像認識を行う場合を例にとれば、Input層は手書き数字の画像サイズ28画素×28画素=784ユニットとなる。Hidden層には100ユニット程度が用いられるケースが多い。最後のOutput層は認識する数字の種類0~9の数と同じになるので、10ユニットとなる。つまり、入力画像が「0」であれば出力層の上から1番目のユニットの出力値が最大となり、入力画像が「1」であれば上から2番目のユニットの出力値が最大、「2」は3番目、「3」は4番目、、、「9」は10番目のユニットの出力が最大となるように機械学習させる。

ニューラルネットワークを作成する上での重要なポイントは結合荷重の設定である。図1の下の方に具体的な結合荷重の数を示した。W10は入力層とHidden層の間、W21は出力層とHidden層の間の結合荷重である。添え字wは荷重パラメータであり、添え字bはバイアスパラメータを示す。初期値にはランダム値が設定される。

このように従来のニューラルネットワークでは、図1のようなシンプルな層構造を持っている。

これに対し、ディープラーニングで画像を認識させる場合には、図2のような構造を取る。

ここでは画像認識で最も高い性能を上げているコンボリューショナルニューラルネットワークで手書き数字画像を認識する場合の一例を示した。図2に上の方に青い枠で囲まれた部分がディープラーニングの構成層を示し、その下の緑色の枠で囲まれた部分が演算に用いるフィルターである。その下に層を構成するユニットの模式図が描かれており、そのユニット数が紫色の下線を持つ数字で示されている。一番下のオレンジ色で囲まれた部分が各層間の結合荷重の構成を示している。

これらを具体的に説明する。図2の上の方で青い枠に囲まれている各層は、Input層、特徴マップ層Fmap1、MaxPoolingされた層S1、特徴マップ層Fmap2、全結合層HiddenF3、Output層で構成されている。

Input層には2次元画像28*28画素をそのまま使う。特徴マップ層Fmap1の1ユニットはInput層に5*5画素の畳み込みカーネルConv-karnelフィルタを掛けることで算出される。Input層28*28の画像の上に橙色の正方形で示されているカーネル領域を左から右に順番に移動させて、Fmap1の全てのユニットの値を算出する。Fmap1は4枚で構成されているので、この操作を4回繰り返して、4枚のFmap1を算出する。同じ操作を4回繰り返して4枚のFmap1を生成するが、演算に用いる結合荷重が異なるので、4枚のFmap1は全て異なる値を持つ。結合荷重の初期値はランダムに設定される。機械学習の過程では教師データの値をフィードバックするバックプロパゲーションにより結合荷重の値が更新される。

このようにして生成されたFmap1層に2*2ユニットのMaxPooling処理をして、S1層を算出する。2*2ユニットのMaxPooling処理とは、縦2横2のユニットの中の最大値をS1層に代入する処理のことである。そのため、S1層のサイズはFmap1の縦横の半分になり、面積としては1/4になる。MaxPooling処理では、特徴マップの枚数に変化はないので、Fmap1が4枚なら、S1も4枚となる。

特徴マップFmap2はS1に対し、5*5*4fのConv-karnelで畳み込み処理をして算出される。ここで5*5*4fは5*5ユニット×特徴マップ4枚の畳み込み演算のことであり、4枚で構成されているS1の同じ位置の5*5ユニットに対して畳み込み処理を行っている。つまり3次元ユニット5*5*4fの畳み込み演算を行っている。ここでFmap2は特徴マップとして8枚を持つ構成にしたので、8枚分同じ処理を繰り返す。ここでも結合荷重の値が異なるので、異なる値を持つFmap2が8枚作製されることになる。

S2はS1とまったく同様なMaxPooling処理である。

このような処理の後、従来のニューラルネットワークのHidden層と同様な全結合層HiddenF3(100ユニット)を設け、これにS2の全ユニットを結合する。この全結合層にHiddenという名前を付けたのは従来のニューラルネットワークと同様の層であるためであり、この層だけがHiddenn(隠れた層)という訳ではない。最後のOutput層と全結合層を全て結合する。

各層をつなぐ結合荷重を図2の下の方に橙色で囲んだW10、W21、W32、W43などで示した。ここで添え字のfは特徴マップ(feature map)の枚数を意味している。

図1のニューラルネットワークと図2のディープラーニングを比較するとよく分かるが、ディープラーニングは従来のニューラルネットワークのInput層とHidden層の間に、畳み込み演算とMaxPooling処理をする数層を挟んだ構造をしている事に大きな特徴がある。

これらの構造の差により、画像認識の性能がどの程度変わるのかを次に解説する。